Jeg må få lov til å være hovedpersonen på min egen blogg. Jeg vil gjerne få fortelle historien om hvorfor jeg ikke tror at dagens politiske virkemidler vil klare å gi oss bedre teknologi. Ja, fordi jeg ser jo det slik at sosiale medier kunne blitt en fantastisk ting for menneskeheten, men at sentralisering av makt i noen få selskap ødela det. Og dette skjedde ikke nå nylig, Facebook var ikke begynnelsen av sosiale medier, det var slutten. Facebook var det som stod igjen når alle kamper var tapt. Dagens AI er heller ikke på noen måte fundamentalt nytt og oppstår ikke som en egen retning, den er et resultat av alt som har gått galt, lagd av folkene som ødela alt. Det kommer ikke til å gå godt.

La meg ta dere tilbake til en lystigere tid, en tid der framtiden så virkelig mye lysere ut, ihvertfall for mine unge øyne. Jeg fikk en konto på Internett av Universitetet i Oslo i 1994. Nettleserne har et valg der man kan gjøre “View Source”, som gjør at man kan se hvordan nettsiden er bygd opp og opplevelsen av at man kunne se hvordan folk lagde ting og forstå det, ja, jeg forsto det, jeg kunne bygge min egne ting. Jeg kunne dele med verden, og vi kunne dele med hverandre.

Jeg så også raskt at standardene ble utviklet i åpne miljøer. Man kunne skrive seg på en e-post-liste og dele ideer, diskutere andres ideer og få forståelse for hvordan man utvikler standarder. Jeg var med på en rekke slike. Det var en tid da teknologiutvikling foregikk åpent med mulighet for å delta.

Det var ikke det at de ikke fantes en tydelig mørk side. En av disse mørke sidene kastet jeg meg hodestups inn i da jeg startet hjemmesidene til foreningen Skepsis i 1996. Jeg var også i diverse nettfora der folk snakket om de merkeligste ting. Selv om jeg syntes de hadde veldig rare ideer var det likevel lett å forstå at de var mennesker, de også. Kanskje derfor ble den mørke siden enda mørkere siden jeg så den sentralisering av makt som var i ferd med å skje. Richard Stallman sitt essay “Right to Read” fra 1997 fanger denne tidsånden godt. Selv om det ikke er så velskrevet science fiction, er det egentlig skummelt realistisk.

Men den som traff aller best når det gjaldt å forutsi framtiden var kanskje den berømte astronomen Carl Sagan. I sin bok “A Demon-Haunted World” skrev han i 1995:

I have a foreboding of an America in my children’s or grandchildren’s time — when the United States is a service and information economy; when nearly all the key manufacturing industries have slipped away to other countries; when awesome technological powers are in the hands of a very few, and no one representing the public interest can even grasp the issues; when the people have lost the ability to set their own agendas or knowledgeably question those in authority; when, clutching our crystals and nervously consulting our horoscopes, our critical faculties in decline, unable to distinguish between what feels good and what’s true, we slide, almost without noticing, back into superstition and darkness. The dumbing down of America is most evident in the slow decay of substantive content in the enormously influential media, the 30 second sound bites (now down to 10 seconds or less), lowest common denominator programming, credulous presentations on pseudoscience and superstition, but especially a kind of celebration of ignorance. As I write, the number one video cassette rental in America is the movie Dumb and Dumber. Beavis and Butthead remains popular and influential) with young TV viewers. The plain lesson is that study and learning — not just of science, but of anything — are avoidable, even undesirable.

We’ve arranged a global civilization in which most crucial elements — transportation, communications, and all other industries; agriculture, medicine, education, entertainment, protecting the environment; and even the key democratic institution of voting — profoundly depend on science and technology. We have also arranged things so that almost no one understands science and technology. This is a prescription for disaster. We might get away with it for a while, but sooner or later this combustible mixture of ignorance and power is going to blow up in our faces.

Det var en slik forståelse av verden som gjorde at jeg begynte med Skepsis i utgangspunktet. Det er viktig da å forstå at massemediene var skikkelig dårlige. De har blitt langt bedre nå, men da var de svært uetterrettelige når det kom til naturvitenskap. I denne perioden opprettet også professor i kjemi Martin Ystenes ved NTNU sin “Sprøytvarsler”-blogg.

“Men på Internett er det ikke dem, det er bare et veldig stort oss“, skrev den svært gode science fiction-forfatteren Douglas Adams i 1999 (Mest kjent for “Hikerens guide til galaksen”). Å, jeg elsket det essayet. Jeg gjør det egentlig fortsatt, fordi jeg så veldig unner barna mine å få leve i en verden så naiv som det Douglas Adams beskrev. Ikke fordi den var slik da, men fordi verden burde gå framover slik at den blir slik.

Essayet peker på de mange moralpanikkene som drev debattene. Det peker på at det viktigste vi vant var interaktivitet. Vi kunne publisere, vi kunne møte andre mennesker, vi kunne forstå dem og de kunne forstå oss. Vi kunne bygge ting som veldig mange mennesker kunne ha nytte av. Essayet påpeker at teknologien allerede var sosial, der mobiler ble vanlige, ble SMS en viktig måte å være sosial på. For oss som opplevde dette var det så uendelig verdifullt, det var en måte å være sosial på som styrket menneskelige bånd. Jeg hadde venner i bryllupet mitt jeg hadde møtt på IRC. Vi har fortsatt kontakt.

I disse sosiale mediene kunne jeg møte noen som mente jeg var med på en konspirasjon for å ta over verden. Det at jeg mente at vi ikke hadde romvesener rundt oss var uttrykk for at jeg var med på denne konspirasjonen, sa dem. Men jeg kunne prate med dem og etablere en felles forståelse. Jeg klarte kanskje ikke å overbevise dem om at en konspirasjon ikke fantes, men jeg kunne overbevise dem om å at den ondskapen de så ikke fantes, og jeg kunne forstå at det fantes en vond bakgrunn for deres tro.

Det gikk ikke like bra overalt. En del av nettet som kom før Webben het USENET, som var delt opp i titusenvis av tematiske grupper. En av disse gruppene var alt.fan.pooh, som var dedikert til fans av Ole Brumm. Man skulle tro at Brumm-fans var de fredeligste av alle mennesker på planeten, men denne gruppa brøt stadig ut i kriger over om Disney-brumm var ekte saker. Jeg er ikke i tvil om at mediet har mye å si for hvor godt dialogen fungerer og USENET var ikke spesielt godt egnet. Men min andre erfaring var at det er mulig å skape broer.

Men da måtte vi ha en kritisk debatt som var både effektiv, brobyggende og opplysende. Erfaringen fra 1997 ble at problemet ikke var å få informasjon ut, det var ikke fakta som betydde all verden. Det handlet om å få kunnskap inn i lukkede sinn. Og dermed måtte man forstå hvorfor de var lukket, men det var en problemstilling som ble for vanskelig. Jeg begynte derfor å tenke på en løsning der vi kategoriserte artikler i forskjellige områder og der vi kunne tydeliggjøre hva som var kritikk eller støtte til hva. Tanken var at nettleserne kunne komme med en liten linje som fortalte at de du så på var kritisert av en artikkel på et helt annet sted på nettet, eller at søkemotorene kunne gjøre det samme. Jeg satte opp en e-post-liste der en løs gruppe drodlet litt rundt disse ideene. Men først måtte jeg gjøre ferdig mitt hovedfag i teoretisk astrofysikk. Jeg fikk litt penger til det av Skepsis, og i mellomtiden hadde andre også fått liknende ideer. Vel, man kan vel si at det var overambisiøst og langt foran infrastrukturen som kunne ha hjulpet det opp. Vi er nå i 2002-2003.

Internett vokste gjennom denne perioden, og det betyr at det var tross alt få som var på nett i perioden og totalt sett få som fikk oppleve det jeg gjorde. Dessverre tror mange at Facebook var starten på sosiale medier. Det preget også forskningen, man etablerte omtrent ingen akademisk forståelse for det jeg opplevde, og først i 2005, altså året etter at Facebook kom, etablerte Forskningsrådet VERDIKT-programmet der sosiale nettverk var et av tre hovedtema. Forskningen kom altså ikke i gang før alle kamper var tapt, den kom når den virkelige interaktiviteten vi hadde ble redusert til posering og brubyggingen var avsluttet, og sentralisering av makt i noen få selskaper var etablert.

Likevel hadde jeg troen på kraften i sosiale medier. Jeg jobbet et par år på My Opera Community, som var Opera Software sitt forsøk på å lage sosiale medier. Jeg prøvde å overtale ledelsen til å la det få ta en annen retning: I stedet for et sentralisert sosialt medium, skill dataene fra applikasjonen slik at hvem som helst kan bygge sin del, og så kan vi heller prøve å gi den beste brukeropplevelsen til dette. Jeg hadde ikke tro på at vi ville kunne konkurrere når det var kjemper på vei opp med enorme mengder penger, som MySpace på den tiden. Jeg fikk oss invitert inn i et stort forskningskonsortium for å jobbe med dette, men ledelsen var ikke interessert.

Det er ikke lett å gi opp en ide som har satt så dype spor i en. Det var ikke før i 2007 at jeg virkelig ga opp troen på at datidens sosiale medier kunne endres til å bli noe bra.

Men la oss gå tilbake til Douglas Adams sitt essay. For meg som var 21 år gammel da jeg først lagde en hjemmeside var det lett å glise gjenkjennende til hans tre regler for hvordan man forholder seg til oppfinnelser:

- alt som finnes i verden da du blir født er bare normalt;

- alt som blir funnet opp mellom da og før du fyller 30 er veldig spennende og kreativt og med litt flaks kan du lage en karriere av det;

- alt som blir funnet opp etter at du blir 30 er mot naturens orden og begynnelse på slutten av siviliasjonen som vi kjenner den, til det har vært der i rundt ti år, da det begynner å bli greit likevel.

Når jeg hører folk (som digitaliseringsministeren) snakke om AI i dag, så ser jeg den entusiasmen som ligger i punkt 2. Jeg ser at den entusiasmen jeg følte for Webben og de tidlige sosiale nettverk. Så er det bare det at jeg nå har havnet i punkt 3 på grunn av alderen?

Dagens sosiale medier har vært her i 20 år, og har ikke blitt greit. La meg fortelle om Hossein Derakhshan. Derakhshan kommer fra Iran og startet en bevegelse med blogging. Han fikk i gang en samfunnsdebatt som landet så sårt trengte og som det ikke var plass til noen andre steder. Han bodde i Kanada, men flyttet tilbake til Iran for å være nær folkene han brydde seg om og skrev om. I 2008 ble han arrestert og dømt til nesten 20 år fengsel. Han ble frigitt i 2014. På siden av historien med undertrykkingen i Iran skrev han om hvordan Webben endret seg på de 6 årene han satt inne. Som han noterte, skrollingen vi driver med i dag er ikke virkelig sosial. Vi har mistet mye av den virkelige interaktiviteten vi hadde med den tidlige Webben.

Det skjedde nesten umerkelig for det fleste av oss, men det var akkurat det som gjorde meg så lei meg da jeg til slutt ga opp. Først nå begynner samfunnet å se det, men fordi så få har opplevd hvordan en sosial Web virkelig kan være, så er det en generell backlash for sosiale medier og ikke et forsøk på et etablere noe bra.

Vi har mistet den verdien som Douglas Adams så i 1999, og derfor tror jeg at han ville vært enig med meg i at det er ikke bare meg som har blitt gammel. Det er faktisk slik at dette har vært med oss i 20 år og har blitt noe helt annet enn greit. Tiktok er så dårlig at barna min skulle ønske at det ikke eksisterte selv om noen av dem bruker det hver dag.

En som også viste at det kunne bli bra er den berømte psykologen Martin Seligman. I boka Flourish skriver han om et møte med store teknologiselskap i 2010, deriblant Facebook. Han skriver at han sa (lett omskrevet): “slik det står nå så kan Facebook faktisk være i gang med å bygge fire av elementene i well-being: positive følelser, engasjement, positive relasjoner og prestasjon. Det femte elementet må dere jobbe med, i det narsissistiske miljøet på Facebook haster det å bygge noe for å kjenne at man er med på noe større enn seg selv, finne en mening”. Facebook valgte å gjøre det motsatte, selvfølgelig.

Sosiale medier kunne blitt noe som er virkelig bra for menneskers well-being, det kunne bygd bruer for å dempe konflikt, det kunne forbedret offentlig debatt, det kunne bidratt til å dempe informasjonsforurensing, det kunne ha ført mennesker nærere hverandre, både ved å gjøre at vi kommer fysisk sammen der det er mulig og virtuelt der det blir for vanskelig.

Joda, til en viss grad har det også gjort det, men til en mye mindre grad enn det kunne. Vi har hele veien gjort valg som har ført oss kollektivt inn i denne krisesituasjonen vi er i nå. Det er kun menneskeskapte ting her, dette er resultat av aktive valg, ikke naturlover.

Det skjedde noe spennende i 2009, da Elinor Ostrom fikk “Nobelprisen” i økonomi. Jeg skal innrømme at min førstereaksjon var at utvikling av “commons” eller allmenninger på norsk var noe programvaremiljøet hadde drevet med i årtier, ja, det er jo dette som ligger bak “Open Source”, som i dag omfatter det aller meste av programvare. Men der holdt jeg på å miste et stort poeng. Mennesker har holdt på med dette i tusener av år, og har blitt skikkelig gode på det. Det har kommet på moten å snakke om “tragedy of the commons”, at alle bare er egoistiske aktører som ødelegger for felleskapet, men Ostrom viste at det er unntaket, at hovedregelen er at mennesker er flinke til å organisere seg rundt allmenninger. Det å skrive “open source” eller fri programvare er noe jeg har drevet med i siden 1995.

Egentlig tok jeg et skritt vekk i 2010 da jeg begynte på en ph.d. i informatikk ved Universitetet i Oslo. Jeg kjente på at det ikke var så mye mer IT-industrien som jeg da egentlig hadde jobbet i 8 år, kunne gjøre. Men også her var den enkleste veien å gå en vei mot sentralisering av makt. La meg ta dere tilbake til en akademisk konferanse i 2012, der en ledende forskergruppe presenterte “Learning from the History of Distributed Query Processing: A Heretic View on Linked Data Management”. Bakgrunnen er at en del akademikere, meg seg inkludert, hadde argumentert for at mange ting ville bli enklere om man ikke sentraliserte data, men holdt det under kontroll av organisasjonene som uansett var nærmest dataene. Dette var det dominere synet, såpass sterkt at de følte for å kalle arbeidet sitt kjettersk. Jeg har alltid likt en god kjetter, og det gjorde visst resten av publikum også, kommentarene i ettertid var stort sett for å takke forfatterne for å endelig ha sagt det mange hadde tenkt.

Men min motivasjon var helt anderledes: De sosioteknologiske følgende av sentralisering, for demokrati, for skaperevne og for menneskers frihet er så store og alvorlige at vi må få til desentralisering på tross av at det er teknologisk vanskeligere på alle mulige måter. Da jeg senere møtte lederen for denne forskergruppen under et Dagstuhl-seminar klarte jeg å overbevise ham om at dette gjør det til et viktig mål for forskning. Min ph.d. er derfor motivert ut fra sosiale, og ikke teknologiske mål.

Blant disse mål er også å sørge for at man ikke skal måtte oppgi mer data om seg selv enn strengt tatt nødvendig. Forløperteknologien relasjonsdatabaser (som fortsatt er svært vanlig) består av tabeller og databasene liker ikke at det er felter i tabellen uten noe i. Teknologien jeg jobbet med tar et oppgjør med dette og legger til rette for at man like greit skal jobbe med data med hull. I personvernforordningen GDPR prøvde EU å legge inn et prinsipp om “dataminimering”. Dataminimering fører til at man kommer til å få hull i dataene, men har blitt et av de mest ignorerte prinsippene i GDPR, ikke minst fordi maskinlæringsfolkene ikke liker “hull i tensorene”. De problematiserer voldsomt rundt det og påstår gjerne at “teknologer ikke liker dataminimering” og at det er “bare sånn teknologien er”. Ikke hør på dem, de som sier sånt forsvarer bare et teknologisk hegemoni som er skapt av nøyaktig dem som ødela sosiale medier.

Men la meg bli litt lystigere en kort stund: Min karriere tok en veldig spennende vending da jeg fikk vite om at “noen folk i Boston” drev med en startup rundt Solid, et prosjekt jeg allerede kjente ganske godt, faktisk var mye av det jeg gjorde helt fra da jeg oppdaget RDF relevant. Jeg ble første ansatte i Inrupt i juni 2018, og folkene bak var blant andre Tim Berners-Lee, som er kjent som han som fant opp Webben. Jeg hadde møtt ham flere ganger i årene før også. Det første halvannet året var Inrupt det mest stimulerende miljøet jeg har vært i i min karriere. Tim ble utropt til “Boldness in Business person of the year” av Financial Times, en artikkel som beskriver veldig godt hva vi trodde på. Min jobb beskrives der også, “å skrive ned ting på en veldig tydelig måte”. Jeg er fortsatt litt involvert i noen av disse dokumentene, det mest sentrale er protokollen som ligger under hele teknologien. Vi var tilbake til den tiden der alt kunne gjøres i offentligheten og folk kunne involvere seg, men med 20 års erfaring og ph.d. i feltet satt jeg nå på toppen av det hele. Det var en litt rar opplevelse. Medier og politikere er ekstremt opptatt av celebritet, det er bare celebriteter som blir spurt om å uttale seg, og som faktisk kan påvirke politikken. Med dette fikk jeg også litt av celebritetens lys på meg. Det resulterte blant annet i et intervju i Dagsavisen. Det er spesielt å se tilbake på nå, fordi jeg trodde på det jeg sa. Jeg hadde internalisert selskapets budskap. Jeg trodde virkelig at hvis vi ga folk tilbake kontrollen over egne data ville en revolusjon følge.

Det tror jeg ikke lenger. Jeg tror ikke på noen enkelttiltak lenger, det er ytterst komplekst, men det jeg er helt sikker på er at vi mangler samfunnsinstitusjoner for å takle det.

Det kom inn et lag med mellomledere i selskapet, og de hadde helt andre ideer om åpenhet. For dem var det kun et skalkeskjul for å sette agenda selv og styre teknologiutviklingen helt og holdent på selskapets premisser. De diskusjonene som vi hadde hatt åpent ble flyttet inn bak lukkede dører. Det var ingenting nytt og ingen virkelig innovasjon i dette, det handlet bare om makt. Bisart nok ble forretningsmodellen å selge en server, mens min jobb, å skrive klart og tydelig hvordan ting skal fungere vil gjøre det enkelt å lage en sånn. Hvis jeg gjorde jobben min bra ville f.eks. Amazon enkelt utkonkurrere min arbeidsgiver. Dermed ble det sånn at min egen arbeidsgiver prøvde å underminere jobben jeg gjorde på alle mulige måter for å bedre sin egen konkurransesituasjon, samtidig med at de kommuniserte utad at de var så åpne. Commonswashing kalles det. Med tiden har ideen om at enkeltpersoner skal kontrollere sine egne data egentlig forsvunnet, forsøkene på å balansere teknologiselskapenes makt og desentralisering likeså.

Det som kunne ha reddet situasjonen der og da var en ny type samfunnsinstitusjon som kunne ha gått inn direkte med utviklingsressurser i økosystemet, da kunne vi ha balansert makten direkte ved å ha implementasjonskapasitet, vi kunne gjort det helt klart at lukkede strategier ikke ville tolereres og vi ville visst når det skjer. Politikerne er forståelig nok redd for å gjenta Quaero-fiaskoen, men den angsten bør ikke stoppe nye institusjoner satt opp som et selskap i reell konkurranse (man bør heller være skeptisk til ting som European Data Spaces, som er satt opp mye likere Quaero-konsortiet). Nøkkelen er å skape reelle økosystemer, ikke å etablere konkurrerende plattformer. Det vi først og fremst mangler er en tilstrekkelig forståelse for hvordan økosystemene bør fungere, men det hjelper ikke at ingen har mulighet til å prøve å skape dem.

Så lenge vi ikke har dette klart vil ikke innføringen av AI gå noe bedre. Det vi tenker på som AI i dag er et ektefødt barn av overvåkningsøkonomien og ekstraktivismen. Her er det maskiner som henter ut verdier av andres arbeid. Nå må vi ikke falle i fella med sentralisering av makt igjen, fordi det vil kun styrke de samme kreftene, og jeg er redd det er dit vi er på vei.

Men når det gjelder AI, så er det mulig jeg bare er i punkt 3 igjen. Mitt felt var nemlig i utkanten av AI-feltet, men for å forstå det litt bedre må vi tilbake til en rekke bøker av Hubert Dreyfus på 60 og 70-tallet, der han kritiserte en form for AI som antok at vi kunne ha symboler om alt og at vi kunne manipulere disse symbolene for å lage kunstig intelligens. Dagens maskinlæring har til en viss grad frigjort seg fra disse antakelsene mens min retning tenkte mer “greit nok, Dreyfus hadde mye rett men hvilke nyttige ting kan vi likevel gjøre hvis vi bare styrker menneskeheten slik at alle kan bidra”. Jeg for min del har aldri hatt kunstig intelligens som mål (hva er intelligens anyway?), men jeg tror vi kunne gjort mye bra på denne måten med en veldig liten brøkdel av ressursforbruket som den galskapen av AI krever i dag. Jeg tror heller ikke det ressursforbruket kommer til å være greit nok om 10 år. Jeg føler at vi har lagt ned et forskningsfelt basert på samhandlingen mellom menneske og maskin, for heller å kaste enorme mengder av jordas energi- og mineralressurser på problemet i stedet, med lite ide om hva vi faktisk vil få ut av det.

Så, hvor står vi nå? Jeg leste en gang en diskusjon (husker ikke hvor) rundt de amerikanske tenkerne som la grunnlaget for USA, og om kontrasten mellom deres tanker om likhet mellom mennesker og viktigheten av frihet, samtidig som slaveriet var påtakelig fraværende fra diskusjonen. De manglet tilsynelatende kreativitet nok til å se for seg at samfunnet kunne utvikle seg uten slaveri. Man ga slavene mat så de kunne bruke 100 watt til å opprettholde livet og dermed kunne man ekstrahere enda 100 watt arbeid. Slaveriet måtte oppgis på moralske kvaler lenge før man faktisk hadde en erstatning, men den industrielle revolusjon kom med sine maskiner og vevstoler og dampmaskiner som kunne gi langt høyere effekt. Det var mye som gikk galt i den industrielle revolusjon også, men det ga løsninger som tenkerne 100 år tidligere ikke kunne forestille seg.

Jeg føler at samfunnet er i en liknende kreativitetskrise i dag. Vi klarer ikke å se for oss et samfunn uten Big Tech. Vi klarer ikke se for oss et lavkarbonsamfunn heller. Og vi våger oss ikke utpå uten å ha alternativene klart og tydelig på plass. Men fordi vi kollektivt mangler forestillingsevnen, så prøver vi heller ikke. Dystopiene er så lett å skrive, men denne gangen ønsker jeg ikke å skrive om dem, heller peke på at jeg tidligere har skrevet om hva vi bør få til.

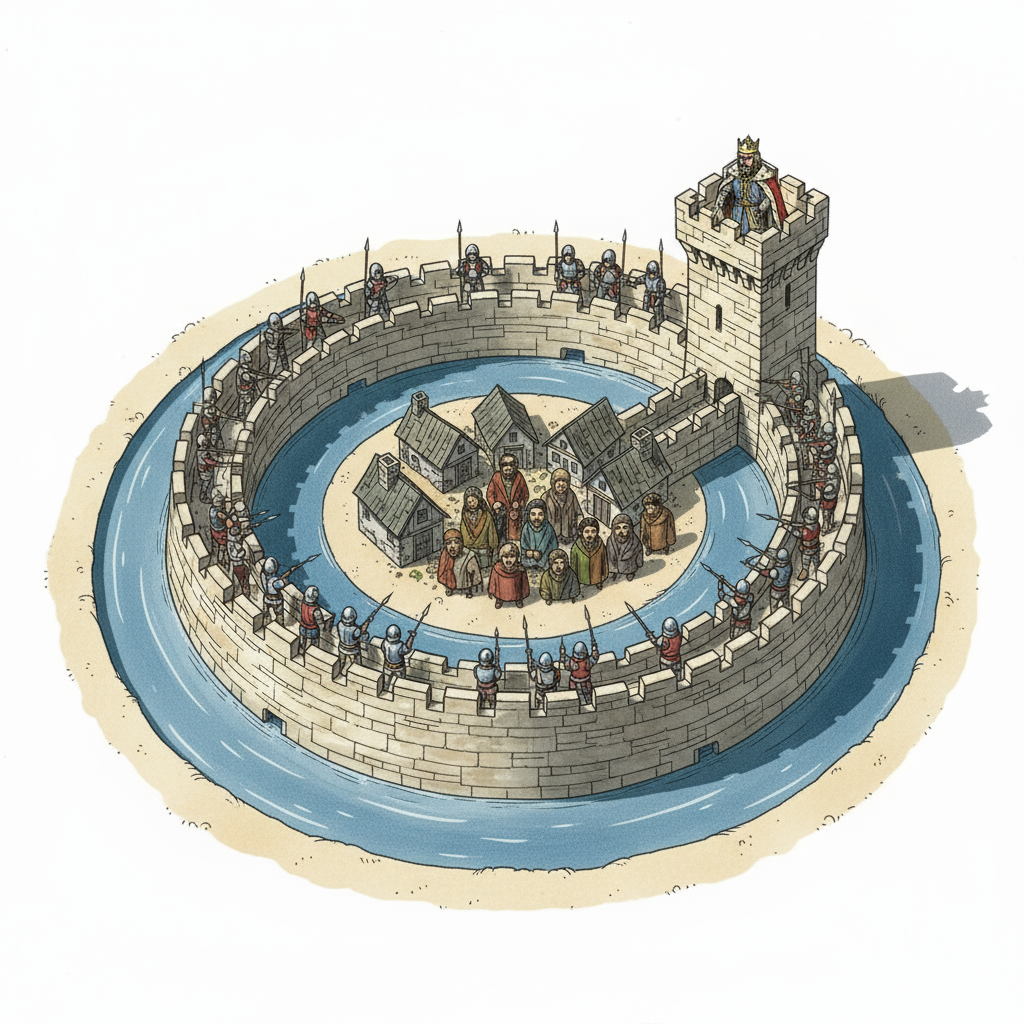

Når Sagan påpekte at kunnskapen sitter hos de få skulle jeg ønske at jeg kunne si at det ikke er riktig. De få som innehar denne kunnskapen bruker gjerne dette til å påstå at de har en legitim makt, deres kunnskap gir dem denne makten. Dette er en ideologi jeg tar avstand fra på det sterkeste, det er nemlig den som er årsaken til mange av våre problemer. Men det er riktig at kunnskapen sitter hos de få, det er ikke til å komme unna, og det absolutt mest kritiske vi må gjøre er å sørge for at dette ikke lenger er sant.

Problemet er tildels denne ideologien, men også helt vanlig business strategy. Man har et rammeverk som heter VRIN/O og der bør man se om man kan ha noe som er sjeldent og ikke så lett å imitere. Det er åpenbart at programvareselskaper er kunnskapsbedrifter, og det betyr at man selvfølgelig søker å ha eksklusiv kunnskap. Og dermed havner kunnskapen helt naturlig hos de få. Det er ingen stor konspirasjon bak det, ingen reinspikka ondskap. Bare helt vanlig business strategy. Men når det betyr at kunnskapen om teknologi som skaper normer i samfunnet er i en bedrifts eksklusive eie, så går det galt. Da må samfunnet finne en annen modell.

Og det er nettopp den modellen jeg prøver å skrive om både her, i kronikker og på Normative Technologies. Og det er her alle trådene egentlig bindes sammen. Selv om vi har vært ganske gode til å lage meritokratiske styringsmodeller for fri programvare, så har vi aldri klart å lage styringsmodeller som faktisk gir en demokratisk forankring. Så her slutter altså historien, for jeg er sikker på at det er slik vi må finne ut av for framtiden, både for å sikre politisk styring med normdannelse og fordi vi må få kunnskapen ut av hendene til de få. Det at Ostrom viste hvordan vi kan lage styringsmodeller gjør at vi i framtiden må snakke om Digital Commons.